备份文件泄露

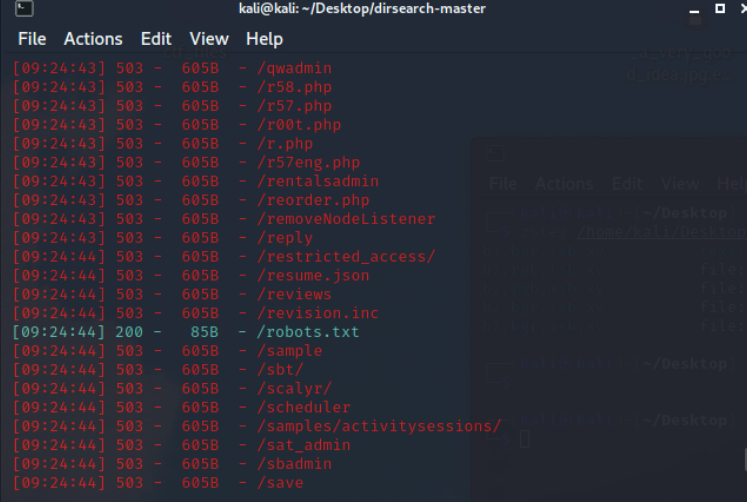

disearch目录扫描工具

下载地址

我是放在kali里面的

使用方法:就是用python运行disearch.py文件

./dirsearch.py -u 地址 -e php

-u 指定url

-e 指定网站语言

-w 可以加上自己的字典(带上路径)

-r 递归跑(查到一个目录后,在目录后在重复跑,很慢,不建议用)

–random-agents 使用代理(使用的代理目录在uesr-agents.txt中,可以自己添加)

根据状态码查看是否存在

所以扫描出了有robots.txt

常见网站备份文件后缀名和文件名

文件名:’web’, ‘website’, ‘backup’, ‘back’, ‘www’, ‘wwwroot’, ‘temp’

后缀名:’tar’, ‘tar.gz’, ‘zip’, ‘rar’

1 | |

其实和disearch原理类似,都是通过状态码来查看文件是否存在。(disearch可以扫备份文件)

bak文件泄露

有些时候网站管理员可能为了方便,会在修改某个文件的时候先复制一份,将其命名为xxx.bak。而大部分Web Server对bak文件并不做任何处理,导致可以直接下载,从而获取到网站某个文件的源代码

如果打开一个php文件发现什么都没有或报错,可以尝试看看.bak

vim缓存泄露

在使用vim时会创建临时缓存文件,关闭vim时缓存文件则会被删除,当vim异常退出后,因为未处理缓存文件,导致可以通过缓存文件恢复原始文件内容

以 index.php 为例:

第一次产生的交换文件名为 .index.php.swp

再次意外退出后,将会产生名为 .index.php.swo 的交换文件

第三次产生的交换文件则为 .index.php.swn

使用curl访问即可直接看到交换文件的内容

curl是个非常厉害的东西,很多源码直接访问看不了,但是用curl就可以,看看curl 的用法指南 - 阮一峰的网络日志 (ruanyifeng.com)

博客内容大多来自ctfhub,参考博客